Samsung "dá um puxão de orelha" nos usuários do ChatGPT.

O que podemos aprender com esse caso?

E ste texto está dividido em duas partes. Primeiramente, seremos imersos na narrativa que envolve a Samsung e o ChatGPT. Em seguida, exploraremos as lições e reflexões que emergem desse caso, analisando se as organizações estão abordando os riscos da rápida adoção de ferramentas de inteligência artificial generativa de maneira adequada.

Entre Inovações e Sigilo: O Caso Samsung

Estamos na Coreia, março de 2023, um mês em que os dias se esticam sob o calor inclemente do sol. Hoje, em uma sexta-feira imperturbável, o resplandecente calor solar espalha sua familiar aura rotineira sobre a Samsung Electronics. O burburinho da produtividade reverbera pelos corredores, pontuado pelo taquear dos teclados e ocasionais toques de telefones. Nada insinuava a iminente reviravolta que se desenharia dentro daquelas paredes.

Imerso no turbilhão de tarefas e obrigações do dia, Yu-jun encontra-se, uma vez mais, destinado a redigir a ata da reunião que participaria — incumbência que lhe provocava profundo desagrado. Uma tensão o envolvia, pois essa tarefa drenava sua vitalidade criativa. A reunião não carregava em si o peso de um marco histórico; era, meramente, um componente na intricada engrenagem corporativa.

Afundado em suas apreensões, enquanto se dirigia à sala de reuniões e repassava os apontamentos que havia meticulosamente preparado, uma revelação surgiu. Uma ideia que o permitiria escapar das garras da tediosa transcrição que o aguardava. Com seu celular Android nas mãos, gravou todo o conteúdo da reunião.

Após a conclusão da reunião, ele colocou sua ideia em ação. Ao chegar em seu escritório, Yu-jun recorreu ao aplicativo Naver Clova, convertendo a gravação da reunião em texto. Com coragem audaciosa, encaminhou a transcrição ao ChatGPT, requisitando a ajuda da IA para a elaboração do texto que comporia a ata da reunião.

Desconhecido para Yu-jun, suas ações desencadearam uma série de eventos dentro da Samsung. A diligente equipe de segurança e conformidade vasculhava regularmente a rede interna em busca de inconformidades e anomalias. Neste processo, eles descobriram uma entrada enigmática nos registros do servidor — um texto abrangente, repleto de detalhes privados da Samsung, havia sido enviado ao ChatGPT.

A descoberta emergiu para Yu-jun em um escritório discreto, sob o olhar atento da equipe de segurança. Sua abordagem “inovadora” foi descoberta. Sem hesitação, ele confessou sua motivação: escapar da monotonia. O incidente provocou debates intensos internamente, envolvendo considerações sobre a relação entre inovação e conformidade. Apesar da natureza rotineira da reunião, isso não a excluía de conter informações confidenciais da Samsung.

O tempo avançou, e o eco daquela fatídica sexta-feira gradualmente se dissipou. A Samsung Electronics prosseguia com suas operações diárias, até que uma manchete no The Economist Korea trouxe à tona os acontecimentos passados. A divulgação de informações confidenciais ao ChatGPT escapou para a mídia. A reportagem exclusiva publicada pelo The Economist Korea relatava não somente o envio da transcrição da reunião ao ChatGPT, mas também outros dois incidentes nos quais códigos proprietários de programação haviam sido enviados a ferramenta. Poucas horas depois, os principais portais de notícias estampavam a questão de segurança em suas manchetes.

Como consequência, o cenário na Samsung se alterou. A confiança erodiu, o acesso ao ChatGPT foi banido, os protocolos de segurança fortalecidos e novas instruções sobre o uso da IA foram divulgados aos colaboradores. Mesmo assim, as ações de Yu-jun permaneceram como um lembrete incisivo — uma advertência sobre iniciativas que desencadeiam ramificações inesperadas. Os eventos daquela sexta-feira continuaram a assombrar a Samsung Electronics, uma lembrança sombria dos perigos que se escondem nas sombras da tecnologia.

Realidade ou ficção?

Desde seu lançamento no final de 2022, o ChatGPT tem sido destaque nas principais notícias de negócios e tecnologia, chamando a atenção para o potencial transformador da IA generativa e seu impacto na forma como as empresas operam e conduzem seus negócios.

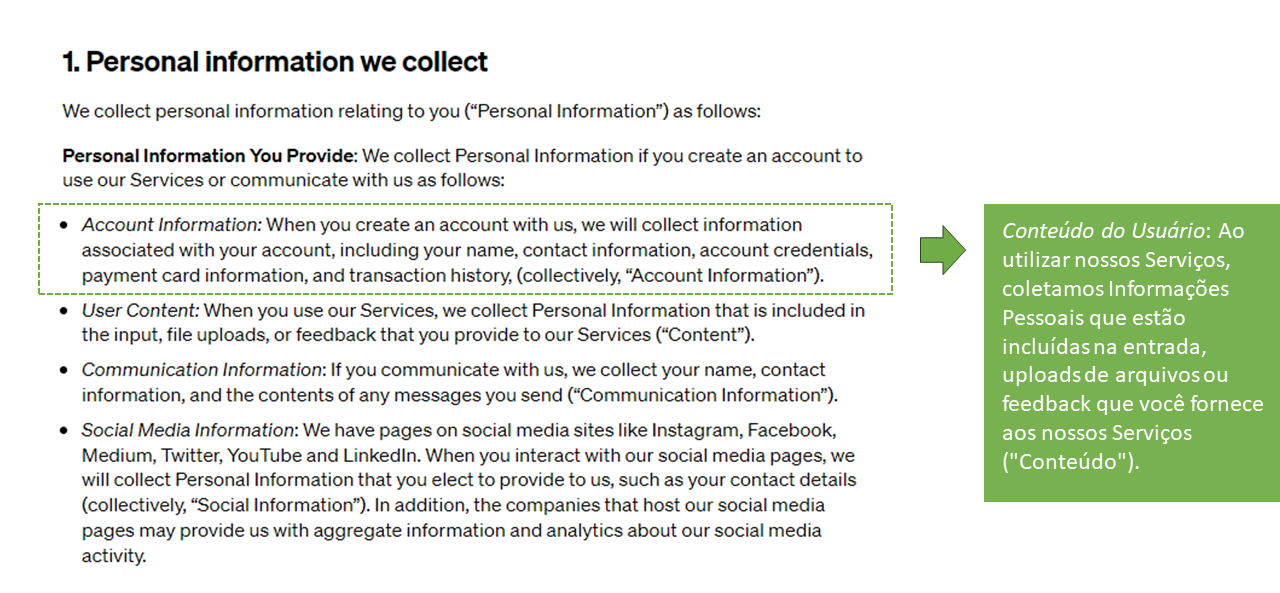

Para a criação da narrativa acima, uma intricada interseção entre fatos e criações da imaginação se entrelaçaram para dar forma ao enredo. Esta mistura foi necessária, porque a Samsung manteve um véu de sigilo no caso. Os detalhes precisos que cercam esse episódio permanecem envoltos em mistério. Mas, para o texto que escrevo hoje, o evento verídico e relevante foi o envio de informações confidenciais ao ChatGPT. À primeira vista, tal envio pode parecer irrelevante, contudo a Samsung tem boas razões para adotar tamanha cautela. Por padrão, a OpenAI armazena todas as interações entre os usuários e o ChatGPT. Esses diálogos são reunidos para o aprimoramento dos sistemas da OpenAI e podem ser analisados por moderadores.

Toda essa empolgação em relação ao ChatGPT e a outras ferramentas generativas, juntamente com o caso da Samsung, me deixaram com uma grande dúvida:

As organizações estão, de fato, avaliando os riscos associados à utilização dessas tecnologias, ou estão focadas somente nos possíveis benefícios?

Desde o início deste ano, tenho colaborado com instituições de ensino para debater os impactos e estruturar o uso das ferramentas de IA generativa em seus ambientes educacionais. Estas instituições estão demonstrando preocupação e se envolvendo em discussões sobre os efeitos decorrentes da utilização inadequada de ferramentas como o ChatGPT, no contexto educacional. Por outro lado, observo que poucas empresas fora do âmbito educacional estão se engajando nessas discussões. Entendo que essa postura é compreensível, uma vez que o risco mais evidente para as empresas é a possibilidade de perder competitividade, caso não incorporem essa tecnologia em suas operações, produtos ou serviços.

As empresas devem se preocupar com o uso inadequado da IA generativa?

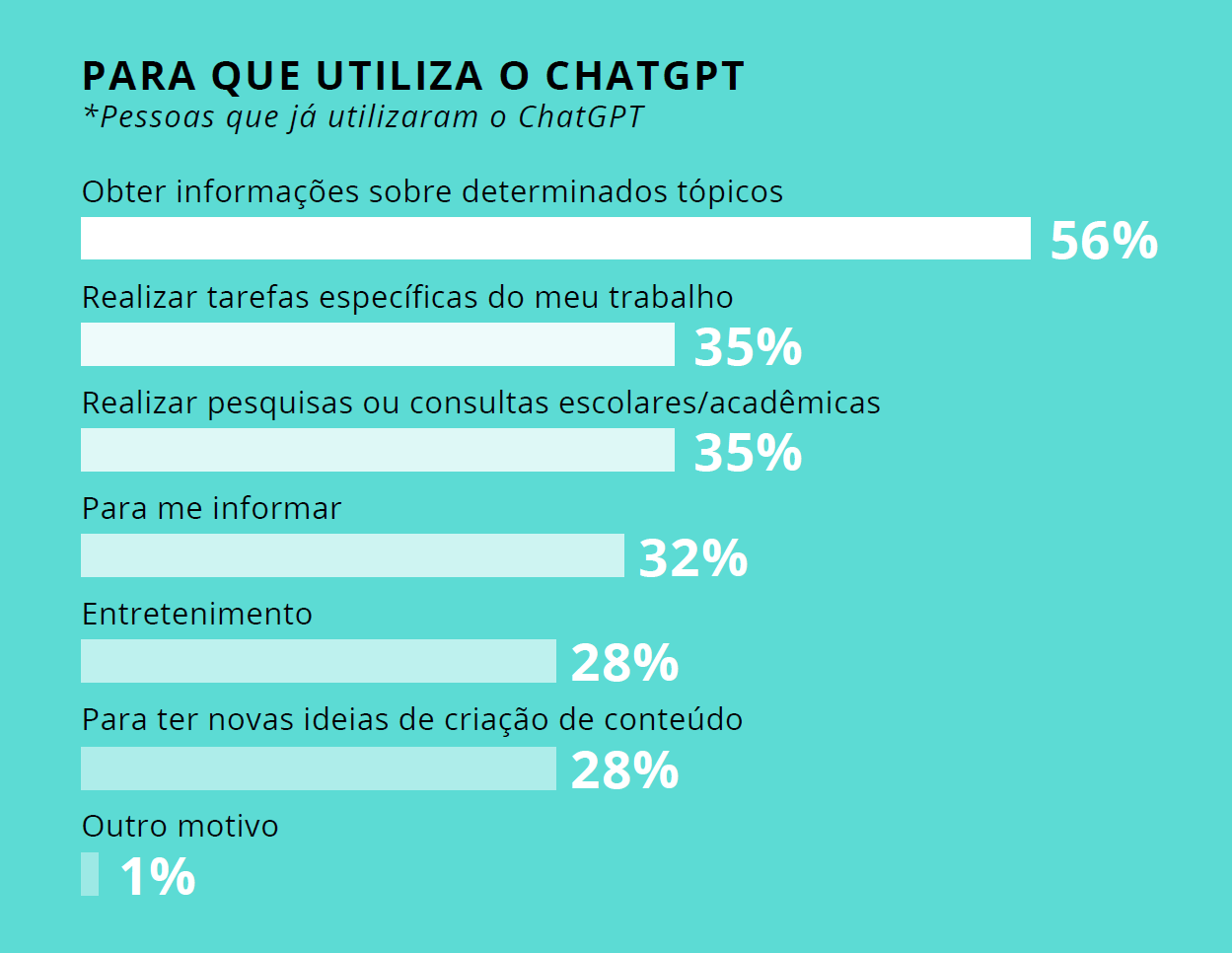

Uma pesquisa realizada pela Opinion Box, em maio deste ano, revelou que mais de 70% dos entrevistados já estavam familiarizados com o ChatGPT. Além disso, impressionantes 42% dos respondentes já haviam utilizado ativamente essa tecnologia em suas vidas. É relevante destacar que essa pesquisa foi conduzida com internautas que são usuários de smartphones, o que implica que eles já possuem familiaridade com tecnologias digitais. É notável como, em pouco mais de seis meses após o lançamento do ChatGPT pela OpenAI, um número expressivo de pessoas já adquiriu, mesmo que em estágio inicial, conhecimento e experiência com essa tecnologia baseada em IA.

Ao aprofundarmos a análise dos dados expostos na pesquisa, um aspecto notável emerge: 35% dos entrevistados que experimentaram o ChatGPT o utilizaram para “Realizar tarefas específicas do meu trabalho” e/ou “Realizar pesquisas ou consultas educacionais/acadêmicas”. Estes resultados trazem uma perspectiva positiva ao revelar que os internautas brasileiros estão acompanhando as inovações e aplicando-as de maneira prática em suas vidas. No entanto, esses dados também deveriam acender um sinal de alerta nas empresas. Uma pesquisa conduzida pela consultoria Oliver Wyman, divulgada pelo The New York Times e realizada com quase 4.500 trabalhadores, revelou que 39% dos entrevistados que fizeram uso de ferramentas de IA generativa admitiram fazê-lo sem o conhecimento de suas respectivas empresas.

Riscos associados ao uso da IA generativa

A adoção da IA generativa traz consigo uma série de riscos que já foram mapeados por especialistas. De acordo com Tate Ryan-Mosley, em um artigo publicado no MIT Technology Review’s weekly, três desses riscos se destacam como particularmente preocupantes: o aumento e amplificação da desinformação, a presença de viés nos dados de treinamento e nos resultados gerados, bem como a deterioração da privacidade do usuário. Além destes pontos, é relevante acrescentar que a utilização de ferramentas de IA, como o ChatGPT, podem também levar à exposição de informações sensíveis da organização, além de suscitar preocupações relacionadas a plágio e violações de direitos autorais.

Dois exemplos práticos. O primeiro eu extraí da própria documentação do ChatGPT, especificamente no texto que aborda as melhores práticas de segurança. Dentro desse tópico, destaca-se o risco de o ChatGPT gerar textos que, embora possam parecer plausíveis, não são precisos nem correspondem à realidade. Esse fenômeno é conhecido como “alucinações da IA”.

O segundo exemplo também envolve o ChatGPT. Em março deste ano, um usuário compartilhou uma imagem que exibia descrições de várias conversas disponíveis na seção “Histórico” do ChatGPT. Na postagem, o usuário afirmou não ter criado essas conversas. O erro, posteriormente confirmado pela OpenAI, apresentava aos usuários títulos de históricos de conversas mantidas com o ChatGPT por outras pessoas.

Os riscos de plágio e violações de direitos autorais tem como origem o processo de treinamento das ferramentas de IA generativa. Muitas dessas ferramentas são alimentadas por extensos bancos de dados que contêm imagens e textos provenientes de diversas fontes, inclusive da internet. Recentemente, a empresa de mídia visual americana, Getty Images, bem como um grupo de artistas, reforçou essa preocupação ao tomarem medidas legais contra os criadores dos geradores de imagem Stable Diffusion e Midjourney. Essas ações judiciais têm como base a alegação de violação de direitos autorais.

Esses exemplos destacam as complexidades e desafios relacionados ao uso da IA generativa, evidenciando a importância de que todas as organizações estejam adequadamente preparadas para enfrentar e mitigar os riscos inerentes a essa tecnologia. Essa abordagem proativa e cautelosa é fundamental para garantir o uso responsável e seguro destas ferramentas, protegendo os interesses das empresas e minimizando os impactos negativos potenciais.

O que fazer? Banir o uso destas ferramentas?

Como consequência do “caso Samsung”, a ação imediata da empresa foi o bloqueio do acesso ao ChatGPT na rede interna. A empresa também fez uma divulgação à imprensa, informando a revisão de seus protocolos e a emissão de novas orientações aos colaboradores sobre o uso da IA. Além disso, a companhia anunciou estar considerando o desenvolvimento de seu próprio serviço de IA, destinado exclusivamente ao uso interno.

Entretanto, o bloqueio de uma ferramenta na rede corporativa não assegura que os colaboradores deixem de utilizá-la em suas atividades. Como ilustrado na imagem abaixo, mesmo quando o acesso não está disponível na rede interna, os colaboradores ainda podem acessá-la por meio de seus dispositivos móveis. Sendo assim, a medida de bloqueio pode, no máximo, fortalecer a política da empresa em relação à não utilização da ferramenta.

Minha recomendação para as organizações é começar pela elaboração de uma política de uso clara e abrangente, que estabeleça critérios para a utilização dessas ferramentas. Adicionalmente, é crucial não apenas divulgar essa política, mas também oferecer capacitação aos membros da organização sobre o funcionamento das IAs generativas, de modo que possam compreender a lógica que está por trás dessas ferramentas. Esse conhecimento é fundamental para que os colaboradores entendam as motivações por trás dos critérios de uso definidos pela organização e percebam a importância de aderir a essa política.

Dado o amplo acesso às ferramentas de IA generativa atualmente, é extremamente relevante que as organizações abordem essa questão de maneira transparente, enfatizando as limitações, os riscos e a necessidade de governança no uso dessas tecnologias.

Parahuari Branco (Parau)

Educação, Tecnologia e InovaçãoCom mais de 20 anos de experiência, Parahuari é apaixonado por educação e tecnologia. Atuou como professor, programador, autor, designer instrucional, gerente de projetos e pesquisador. Ao longo de sua carreira, contribuiu para o desenvolvimento de portais, livros digitais, simulações, sistemas adaptativos e jogos educativos. Atualmente, além de criar ferramentas que incentivam a leitura e a criatividade digital, trabalha com organizações para promover uma adoção responsável da inteligência artificial. Parahuari acredita que transformar a educação é transformar o mundo.